Эволюция архитектуры СХД

Начиная с первого жесткого диска, появившегося в 1956 г., и до наших дней системы хранения данных претерпели большое количество изменений как в форм-факторе, так и в технологии хранения в целом.

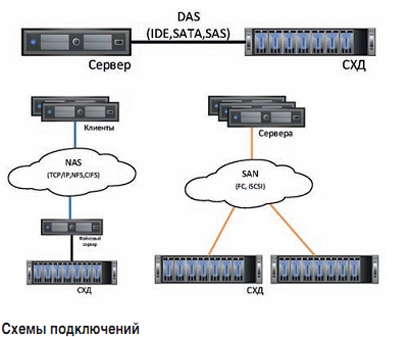

Первые диски и массивы подключались напрямую к серверу и работали только с ним. Такая схема называлась DAS (Direct-attached Storage). Данная система была дешевой, относительно надежной и обеспечивала необходимый уровень быстродействия операций ввода-вывода. Но был один большой минус – эти системы не поддерживали совместного использования емкости хранения разными серверами, что было очень затратно и непрактично. Ни о какой удобной масштабируемости не могло быть и речи.

Следующим типом подключения серверов к СХД стал NAS (Network Attached Storage), представленный в начале 1980-х гг. Первоначально доступ осуществлялся между несколькими машинами системы UNIX. В данной схеме диски и массивы подключаются через локальную вычислительную сеть Ethernet (Fast Ethernet, Gigabit Ethernet), чаще всего по протоколам TCP/IP для передачи данных, SMB (CIFS) и NFS – для удаленных файловых сервисов.

Данная схема уже более гибкая и легко масштабируется. К плюсам также можно отнести дешевизну и доступность необходимых ресурсов для всех серверов и компьютеров компании. Но такой вариант предполагает только файловый доступ к данным, что приводит к большим потерям в быстродействии и производительности, чем у локальных дисков или блочного доступа.

Независимо от NAS разрабатывалась еще одна схема подключения – SAN (Storage Area Network). SAN – это по сути выделенная сеть для блочного доступа к данным. На сервере SAN диск выглядит как обычный локальный диск. Наиболее распространенными протоколами для подключения являются FibreChannel и iSCSI. На сервере необходимо иметь специальную карту – HBA (Host Bus Adapter): она является входной точкой для всех внешних дисков и через ее порты происходит взаимодействие с массивом. Блоки данных и команды SCSI оборачиваются в пакеты FC или IP для iSCSI, а затем передаются на массив.

К плюсам такой схемы можно отнести сам по себе блочный доступ к устройствам – это дает значительный выигрыш в производительности и быстродействии. Данная схема также имеет отличную масштабируемость и огромные возможности для расширения. К сожалению, это решение не является дешевым. FibreChannel обходится дороже, чем iSCSI, но является протоколом с гарантированной передачей данных. При всем этом iSCSI не уступает по производительности, а в некоторых моментах даже впереди FibreChannel.

Все перечисленные варианты имеют право на жизнь в современном мире. Ни один из них не канул в прошлое, а используется до сих пор и продолжает развиваться. Какую схему лучше использовать? Все зависит от размеров бизнеса и его задач. Но чаще всего в современных компаниях совмещают несколько схем для одной системы. Например, имея высокопроизводительный массив, подключают его к серверам баз данных и файловому серверу через SAN-сеть и одновременно конечных пользователей – к файловому серверу через NAS, где они могут хранить файлы для общего доступа.

Массивы данных: история развития

Сами массивы за всю историю СХД также претерпели изменения – от обычных JBOD’ов (Just a Bunch of Disks) до отказоустойчивых высокопроизводительных систем со своей OS. Первые JBOD’ы даже не имели какой-либо избыточности. Они работали как обычные IDE- или ATA-контроллеры, отдавая диски "как есть". Сейчас же даже самое простое устройство способно создавать RAID из нескольких дисков.

Современные массивы в основном делятся на три класса: Entry-Level, Mid-Range и Hi-End. Массивы первого, самого простого, класса могут состоять из нескольких дисков и в большинстве своем не выходят за рамки одной полки с собственным контроллером или без него. Данный класс меньше всего потребляет электроэнергии и является самым тихим. Такое оборудование можно поставить даже у себя дома или в офисном помещении.

Второй класс массивов предполагает более высокий уровень: компоненты массива (контроллеры, элементы электропитания и вентиляции) дублируются, что повышает энергопотребление и уровень шума от оборудования. В случае выхода из строя одного из контроллеров сохраняется доступ к информации, но чаще всего утрачивается половина быстродействия и производительности.

Третий класс массивов самый надежный и потребляет больше энергии, чем остальные. В нем дублируются абсолютно все части. Диски и другие компоненты, отвечающие за обработку и доставку операций ввода-вывода, имеют доступ к контроллерам массива по нескольким путям, что во много раз повышает отказоустойчивость и, что не менее важно, производительность. При выходе из строя любого из компонентов (в т.ч. диска, контроллера) снижение производительности незначительно. Данное оборудование лучше всего размещать в ЦОД, так как оно может занимать несколько отдельных стоек.

Дополнительные функции массивов, такие как локальная или удаленная репликация, тонкое выделение дискового пространства (Thin Provisioning), многоуровневое хранение данных (Tiering), дедупликация и компрессия, чаще всего начинают поддерживаться с Mid-Range-уровня. Именно эти возможности повышают эффективность хранения данных при их постоянном росте. Облачные провайдеры из соображений надежности и высокопроизводительности обычно как раз и используют массивы второго и третьего класса со всеми дополнительными функциями. Немалое преимущество заключается в том, что большинство из них умеет отдавать информацию по нескольким протоколам одновременно (FC, iSCSI, CIFS, NFS), что сокращает затраты на инфраструктуру, экономит ресурсы и упрощает администрирование системы в целом.

СХД на пике популярности

На фоне общего сокращения продаж СХД вследствие падения спроса на традиционные дисковые хранилища с крутящимися жесткими дисками аналитики IDC отметили в первом полугодии 2017 г. быстрый рост сегмента flash-массивов: отгрузки систем, построенных только на массивах flash-памяти, подскочили на 86,5% в денежном выражении и достигли 23,7% от суммарных. Эти данные не удивляют, ведь по цене производительные SSD-диски практически сравнялись с дисками SAS 15k, а по быстродействию flash-накопители выигрывают во много раз. Это и стало решающим фактором при выборе SSD для высококритичных бизнес-систем.

Работая на рынке облачных сервисов, в ситуации аналогичного выбора конечно же, лучше сделать его в пользу SSD-накопителей. Основные массивы работают на flash-накопителях, с включенными политиками QoS на LUN’ах. Это позволяет более гибко подходить к администрированию массивов и выделять клиентам гарантированную производительность без влияния на "соседей".

Помимо классических СХД, все большую популярность набирают SDS-решения (Software Defined Storage, программно-определяемые СХД). По прогнозам Gartner, к 2020 г. 70–80% неструктурированных данных будут храниться на недорогих системах, управляемых с помощью SDS. В таких системах практически вся работа по распределению данных делегируется софту, а под ним может находиться любое физическое хранилище, будь то обычный диск или массив.

Если у вас большой парк оборудования, который включает массивы от разных производителей, то для более гибкого и удобного администрирования такой инфраструктуры их можно подвести под SDS. Это позволит оптимизировать процедуру выделения ресурсов со всех массивов, а также иметь единую "консоль" для операций. Если у вас старое железо и хочется дать оборудованию "вторую жизнь", здесь тоже поможет SDS.

Смогут ли программноопределяемые СХД полноценно заменить классические системы? Каждый на этот вопрос ответит для себя сам. Согласны ли вы мириться с еще одной "прослойкой" между массивом и сервером? Есть ли готовность и силы отказаться от "классической предсказуемости" обычных массивов? Для каких конкретных целей вы выбираете именно эту технологию? Сколько вы готовы потратить на инфраструктуру? На эти и многие другие вопросы необходимо ответить, прежде чем делать выводы.

Какая из описанных систем окажется в лидерах в ближайшем будущем, сказать сложно, большинство технологий меняется год от года. Однако очевидно, что в России рынок СХД будет неуклонно расти – не только из-за всеобъемлющей цифровизации, но и из-за закона Яровой и других актов, обязывающих хранить персональные данные только на территории страны.

Автор: Дмитрий Глушков – системный инженер

Источник: