Децентрализация управления как принцип

Эволюционируют системы управления. Мы пришли к тому, что управлять системами любого типа эффективнее децентрализованными методами. Это касается как социальной структуры компании, так и цифровых технологий.

На языке менеджмента децентрализация ведет к более гибкой и эффективной работе системы процессов в организации и к большим результатам для компании, в том числе финансовым.

А как взглянуть по-новому на управление процессами в вычислительных системах?

Ну что, пора бы уже делегировать вычисления сетевой периферии?

«Облачная недостаточность»

Устройства ограничены по вместимости и вычислительной мощности, поэтому интеграция с облачными устройствами помогает повысить эффективность обработки в разы и использовать практически безграничные ресурсы, а также сэкономить, так как лицензия дешевле, чем стоимость оборудования. Но уже сейчас существует обширная категория контента, например, фильмы высокого качества, которая чувствительна к задержкам сети. А облака не могут гарантировать высокую скорость обработки из-за отдаленного дата-центра. И это только цветочки по сравнению с потребностями IoT-технологий. Как обрабатывать данные, чтобы после этого они оставались максимально актуальными? Нагрузка на ЦОДы увеличивается, необходимы новые. ИТ-инфраструктура – сложно, дорого и долго. А дата-центры ведь и до энергии прожорливые, что, помимо прочего, сказывается на экологии…

А что если данные будут обрабатываться до ЦОДов?

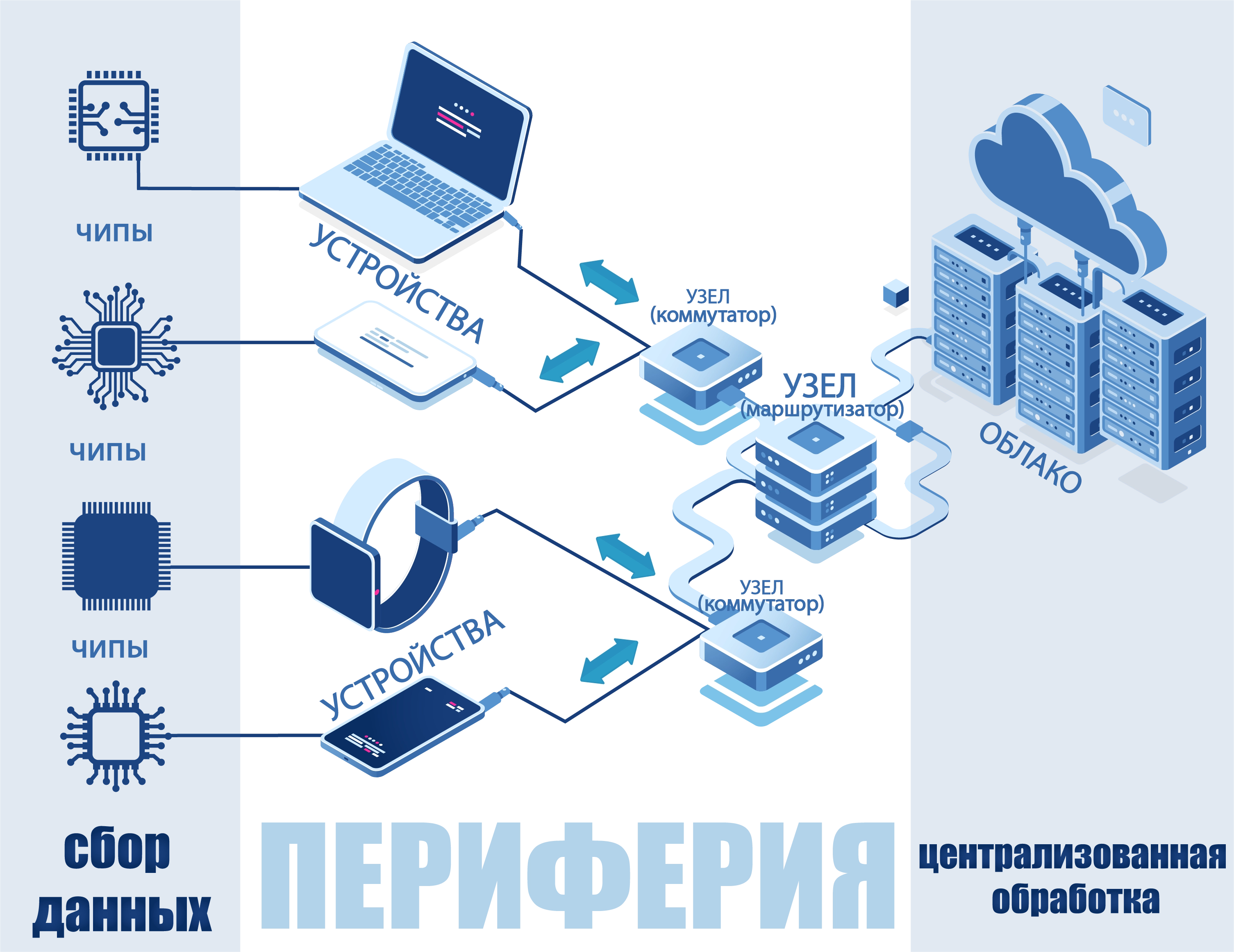

Да, это возможно. И, разумеется, ЦОДы все еще будут нужны. Границы вычислительных возможностей облака расширяются, окаймляясь узлами, подключенными к устройствам. Такие узлы обладают достаточной мощностью, чтобы самостоятельно выполнять вычисления небольших информационных массивов, не отправляя их на удаленный сервер, или делать первичную обработку перед дальнейшей передачей вышестоящему вычислительному узлу. На периферии между ЦОДами и датчиками сбора информации появляются туманные вычисления. Туман включают в себя облако, и вообще он пока не далеко ушел от облаков. Просто он ближе к конечному пользователю, а его компетенции – те же, что и у облака.

Узлами сети являются устройства, соединенные друг с другом. Если ЦОДы по миру измеряются тысячами, то узлы – миллионами! Вычисления на периферии не заменяют, а дополняют облака, и это неизбежно в условиях целевого распространения 5G и IoT-технологий, виртуальной и дополненной реальности, в которых вычисления будут все ближе и ближе к нам. Периферия ─ единственный шанс для ресурсов, у которых нет непрерывного доступа к сети, например, для целей сельского хозяйства.

Вычислительные процессы теряют стационарность, приложения кочуют на периферию. За счет этого данные обрабатываются быстрее. Интеллектуальные приложения и устройства моментально реагируют на свежую порцию данных без задержки на их транспортировку. Для интернета вещей – то что нужно!

Периферийные вычисления станут важнее облачных к 2025 году. Периферийные вычисления способны стать открытой средой, способной беспроблемно взаимодействовать с другими. Она должна быть независимой от оборудования, кремния, облака или операционной системы.

Руководитель сетевых проектов Linux Foundation

Периферийные, туманные, промежуточные, граничные, краевые вычисления (edge/fog computing) – суть одна, называют по-разному. Для обработки информации на периферии узлы, по-хорошему, должны быть оснащены интеллектуальными шлюзами, распределяющими потоки «сырых» данных по разным уровням вычислительной сети. Все вычислительные процессы перемещаются из ядра архитектуры на пограничные сегменты сети. Туман выполняет роль посредника между чипом/устройством и удаленным сервером, а также распространяется и на оборудование. Так периферийный сегмент сети может состоять из нескольких слоев. Вся сеть тогда характеризуется как трехзвенная: датчики собирают информацию, на периферии осуществляется первичная обработка, а в ЦОДы отправляются релевантные данные.

Особенностей у периферии – туча:

Первое и самое очевидное – с помощью тумана можно масштабировать облака. Вычислительные ресурсы возрастают пропорционально. Но в отличие от облака вы не можете сразу добавить новые узлы в существующую инфраструктуру периферийных вычислений.

Обработка на краю сети – дешевле. Экономия достигается за счет совместного использования общих ресурсов в различных приложениях и сокращения использования сетевых, вычислительных и энергетических ресурсов, так как данные обрабатываются локально, не совершая кругосветное путешествие до удаленного дата-центра. Вместо того, чтобы использовать маршрут по схеме «устройство – облако – устройство» в обе стороны, можно просто делегировать часть нагрузки с дата-центра и сети чему-то еще. Для целей машинного обучения или технологии компьютерного зрения особенно важно устранить этап обработки данных в облаке или в ЦОДе;

Отсюда вытекает еще один плюс - ускорение обработки и небольшое время отклика, так как туман – ближе к пользователям за счет распределенной архитектуры. Данные обрабатываются эффективнее – дополнительный слой тумана дает дополнительную среду для обработки;

Контроль процесса обработки в режиме реального времени становится лучше, оптимизируются маршруты доставки информации. Настоящая логистика в цифровой среде! Нет проблем с пропускной способностью – часть информации собирается в разных точках, а не отправляется в центр сети по длинному каналу. А мгновенный отклик и отсутствие простоев улучшают пользовательский опыт и повышают лояльность;

Есть еще момент. Вопрос, конечно, спорный, но считается, что достигается определенная степень защиты конфиденциальных данных за счет того, что данные обрабатываются огромным количеством узлов в сложной распределенной системе, но к этому мы еще вернемся;

У сложной распределенной архитектуры есть еще одно преимущество – достигается высокая отказоустойчивость, хотя все же продумать бэкап-решения или пути восстановления информации с упавших узлов периферийных сетей все же стоит. Любой простой системы замыкается на одной точке в целой огромной сети, а не по всей системе. Увеличивается доступность инфраструктуры.

А ведь это один из главных параметров для провайдеров облачных услуг, работающих с заказчиками, бизнес которых зависит от качества облачного сервиса.

Туман – не панацея:

На периферии могут быть дополнительные ограничения на совместимость ПО или устройств, а также на емкость обрабатываемых данных. Понадобится разработать стандартные протоколы, применимые ко всем устройствам в сети. Кроме того, «периферию» лучше не использовать для ресурсоемких вычислений.

Вернемся к вопросу безопасности сети: конечные устройства более уязвимы для хакерских атак, чем централизованный центр обработки данных. Для устранения этого недостатка надо пересмотреть защиту всей системы: ядро, узлы и каналы. Здесь поможет управление доступом, инкапсуляция данных, шифрование каналов или использование виртуальной частной сети (VPN).

А для сохранности данных необходимо создавать резервные копии данных на периферийных устройствах, чтобы их можно было восстановить в случае сбоя устройства или сети.

Система «менеджмента» для туманных вычислений требует многоуровневого управления ресурсами: и на границе сети и у ядра – совместно с удаленными поставщиками облачных услуг. Для мониторинга и управления периферийными ресурсами могут быть полезны виртуализация сетевых функций(NFV) и программно-определяемая сеть (SDN). Виртуализация сетевых функций помогает также достичь большей безопасности. Эта концепция может применяться к узлам сети для защиты доменов пользователей.

Где можно пощупать туман?

Периферийные вычисления – обработка «сырых» данных не в ядре инфраструктуры, а на локальных ресурсах или в узлах вычислительной сети. Узлы представляют из себя локальные объединенные устройства – маршрутизаторы, шлюзы, коммутаторы, концентраторы, даже небольшие сервера, вынесенные из центрального ЦОД на периферию, микрооблака, а также другие устройства, в том числе компьютеры, смарт-гаджеты и т.д.

Главный принцип туманности – обработка вне ЦОДа, который является ядром вычислительной сети. А релевантные данные уже доставляются в ЦОД на финальную обработку и хранение.

Умные дома и города, беспилотные системы … Обработка информации на периферии – незаменимая вещь для служб, требующих быстрого реагирования, таких как правоохранительные органы и медицинские бригады. Туманные вычисления будут использоваться во многих отраслях, таких как промышленность, розничная торговля, логистика. Они будут повышать эффективность транспортных перевозок путем передачи информации в локальные сетевые системы, наиболее доступные в каждый момент времени. Сейчас туманным вычислениям нужна открытая унифицированная платформа для интегрирования сетевых ресурсов на единой шине.

Многие предприятия используют гибридную архитектуру для повышения производительности ИТ-инфраструктуры. Микс периферии и облака приведет к апгрейду вычислительных возможностей и бизнеса, пользующегося преимуществами обеих моделей – на базе облака и периферии.

Главный принцип: облака – для безопасной и более сложной обработки объемных данных, периферия – для ускоренной обработки небольших массивов. Например, аналитический алгоритм может быть эффективно создан в облаке, и затем перемещен ближе к краевому устройству.

Лучшее на сегодня решение выглядит как объединение двух моделей. Одно известно точно, вычисления в распределенных узлах или на самих устройствах – пока что самое оптимальное, что придумано для процессов, требующих быстрой реакции!